« As-tu déjà peur, humain? » The Guardian nous a demandé dans son article généré par GPT-3. Depuis sa publication, de nombreux utilisateurs ont réagi exprimant leur étonnement et même leur peur car un réseau de neurones peut élaborer des textes aussi complexes que cela. Bien qu’il s’agisse d’un texte édité, retouché et mixé par les rédacteurs en chef du journal, le sentiment troublant de lire quelque chose de «spécial» se répète chez beaucoup d’entre nous.

Cet effet provocateur généré par certains programmes informatiques, IA ou chatbots est connu sous le nom d’effet ELIZA. Et il a été décrit par l’informaticien du MIT, Joseph Weizenbaum. En 1966.

Le premier chatbot de l’histoire était un psychothérapeute

L’origine des chatbots a commencé avec un professeur d’informatique du MIT qui voulait faire une blague des questions que les psychothérapeutes rogériens se posent souvent. Le programme ELIZA a reconnu les mots-clés et les a interrogés comme s’il s’agissait d’un psychologue.

Humano: Bueno, mi novio me hizo venir aquí.

ELIZA: ¿Tu novio te hizo venir aquí?

Humano: Él dice que estoy deprimida la mayor parte del tiempo.

ELIZA: Lamento escuchar que estés deprimida.

Humano: Es cierto. Soy infeliz.

ELIZA: ¿Cree usted que venir aquí le ayudará a no ser infeliz?

Dans le cas où le programme ne détecte pas de mot-clé, le chatbot a répondu avec des phrases génériques telles que « continuer » ou « m’en dire plus ». La réaction des utilisateurs a surpris Joseph Weizenbaum.

C’était un code simple, mais il donnait l’illusion de l’empathie« Je n’avais pas réalisé … que des expositions extrêmement courtes à un programme informatique relativement simple pouvaient induire une puissante pensée délirante chez des personnes assez normales », a-t-il décrit.

Weizenbaum ne s’attendait pas à un tel effet. Les gens étaient ravis. Quelque chose qu’il trouvait dérangeant et inquiétant, les utilisateurs n’ont pas compris qu’ils parlaient à un simple programme. L’effet captivant est connu sous le nom d’effet ELIZA, en l’honneur des réflexions de son créateur sur la façon dont les machines pourraient efficacement imiter un sens de la compréhension humaine et générer des émotions.

Dans les années 1970, l’intelligence artificielle était un domaine très nouveau. Mais alors que certains de ses contemporains étaient optimistes, Weizenbaum a commencé à dénoncer la barrière entre les humains et les machines. Le créateur du premier chatbot et l’un des pionniers de l’intelligence artificielle, il a également été l’un de ses premiers critiques.

L’idéalisation des machines

L’héritage d’ELIZA est toujours très présent aujourd’hui. La définition établie pour décrire cet effet est « le la susceptibilité des gens à rechercher une meilleure compréhension des chaînes de symboles – en particulier les mots – enfilés par les ordinateurs « .

La découverte de l’effet ELIZA a été très importante dans le développement de l’intelligence artificielle, principalement dans les chatbots qui tentent de transmettre des émotions ou tentent de faire percevoir le programme comme quelque chose de plus proche.

On le voit constamment chez des assistants comme celui de Google, qui réclament notre compréhension quand ils ne comprennent pas la question ou dans des robots intelligents qui essaient de se faire passer pour des collègues de bureau, quand ils sont simplement programmés pour nous offrir des réponses qui peuvent nous réconforter.

XiaoIce, le chatbot chinois de Microsoft, a pour mission de devenir «une IA avec laquelle les utilisateurs peuvent établir des liens émotionnels à long terme».

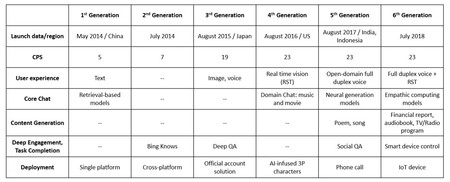

Graphique de l’article « La conception et la mise en œuvre de XiaoIce, un chatbot social empathique » dans lequel ils expliquent leurs différentes évolutions au niveau de l’empathie.

Graphique de l’article « La conception et la mise en œuvre de XiaoIce, un chatbot social empathique » dans lequel ils expliquent leurs différentes évolutions au niveau de l’empathie. Microsoft reconnaît que 70% des réponses de XiaoIce sont dérivées de données glanées dans leurs propres conversations passées et mènent à une conclusion liée à l’effet ELIZA; la durée des conversations semblent être une indication de la satisfaction des utilisateurs. Autrement dit, plus nous passons de temps à parler aux machines, plus nous nous laissons emporter par leurs réponses.

GPT-3: comprendre la machine est de plus en plus difficile

Malgré les progrès, les chatbots modernes et les assistants intelligents comme Siri ou Alexa ne peuvent toujours pas se «comprendre». L’IA conversationnelle est devenue plus fiable et plus agréable, mais elle est toujours le résultat de quelques lignes de code. Et dans certains cas, le résultat est plus monotone et prévisible qu’on ne le pense. Avec des réseaux comme GPT-3, le niveau de complexité est si élevé que Il est plus facile pour nous d’essayer de trouver un sens au résultat que de ne pas découvrir quel est le mécanisme par lequel cette réponse a été atteinte.

Les créateurs du GPT-3 reconnaissent eux-mêmes que « bien que la qualité soit généralement élevée, les échantillons se répètent sémantiquement, perdent leur cohérence dans de longs passages comme un livre de centaines de pages, ils se contredisent et contiennent des phrases ou des paragraphes dénués de sens ».

En utilisant GPT-3 https://t.co/GjJYdAoEf9, un robot écrit cet article dans @Gardien . Cela vous fait-il peur, humain? https://t.co/rHsL6V3o0G

– David Martínez ? (@dmartinezpr) 8 septembre 2020

Parmi les phrases que l’IA publie dans l’article du Guardian, figure celle de «toujours reconnaissant pour les commentaires». Une réponse largement répétée sur internet et celle pour GPT-3 n’est pas difficile à associer au texte. Il est intéressant de noter que dans le même article, une autre phrase est introduite qui est également souvent répétée: l’IA «n’a pas de sentiments». Le même texte nous transporte indirectement vers l’effet ELIZA (en remerciant et en essayant de générer de l’empathie), tandis que reproduit les mêmes arguments que vous avez lus sur votre propre nature (AI n’a pas de sentiments). Le texte n’est pas sans erreurs. Personne n’est parfait. Et l’IA, reflet de nos échecs, n’est pas épargnée non plus.

«Toute technologie suffisamment avancée est impossible à distinguer de la magie», a déclaré Arthur C. Clarke. Weizenbaum s’est rendu compte que même les chatbots les plus simples pouvaient induire en nous une telle implication émotionnelle. Nous savions qu’ELIZA ne simulait pas l’émotion et maintenant nous sommes conscients que GPT-3 n’est pas à la hauteur des normes des journalistes de The Guardian, mais l’effet continue de se produire et les développeurs disposent de meilleurs outils pour que nos esprits ne réalisent pas ce que qu’y a-t-il derrière.

À Xataka | J’ai parlé aux 15 robots les plus populaires et ils sont toujours un vrai gâchis

45secondes est un nouveau média, n’hésitez pas à partager notre article sur les réseaux sociaux afin de nous donner un solide coup de pouce. ?